La teoría conceptual de la metáfora, que hace parte las teorías en semántica cognitiva propuestas por George Lakoff y Mark Johnson (Lakoff & Johnson, 2015), es, en general, una propuesta muy útil para estudiar procesos cognitivos de interpretación subyacentes a los discursos humanos. A grandes rasgos, esta teoría implica entender las metáforas como proyecciones de rasgos conceptuales que van de un dominio fuente a un dominio meta. Un dominio es, por así decirlo, un contenedor de ideas relacionadas con una etiqueta conceptual. Por ejemplo, podríamos decir que el dominio BRUJA contiene rasgos como: hechizo, nariz puntiaguda, encantamiento, brebaje, vuela en escoba, etc.

Normalmente, las metáforas tienen la estructura DOMINIO META es como DOMINIO FUENTE, y una interpretación metafórica consiste en proyectar ciertos rasgos de la FUENTE a la META (Ibarretxe-Antuñano & Valenzuela, 2012). Si lo decimos metafóricamente, consiste en hacer un préstamo de un dominio a otro. Por ejemplo, en el caso de la metáfora X PERSONA es como UNA BRUJA, podrían proyectarse algunos rasgos parciales de bruja sobre la conceptualización de la persona: digamos, es como una bruja porque es fea.

Adicionalmente, para Lakoff y Johnson, las metáforas conceptuales no existen en el terreno retórico y de la imaginación poética, sino que se extienden al terreno de la acción cotidiana. No solo usamos metáforas como expresiones, sino que las vivimos —de hecho, el título original del libro en inglés es “metaphors we live by”— o vivimos mediante ellas. Así, sin que nos demos cuenta, cuando decimos: “¡ya veo!”, estamos metaforizando el entender como ver, o cuando decimos: “estoy perdiendo el tiempo”, estamos metaforizando el tiempo como dinero.

Las metáforas conceptuales no surgen solo en la superficie del discurso, en el texto, y no pueden ser analizadas solamente a través del análisis de las estructuras textuales formales. Como la metáfora es un proceso conceptual, una cosa es una expresión metafórica, es decir, un texto que detona una interpretación en una persona que activa sus capacidades para entender metáforas; otra cosa es la metáfora: la estructura de dominios en su cabeza, que no tienen necesariamente que estar explícitos en el texto; y otra cosa es la interpretación: las proyecciones particulares que un dominio le presta al otro. De este modo, aunque el texto sea el mismo, e incluso los dominios sean los mismos, el sentido de una interpretación metafórica puede cambiar totalmente. Pensemos, por ejemplo, en el caso de una carta de amor en el que una persona le dice a otra: “tú me hiciste brujería” versus una situación en la que una persona, ofendida, le grita a otra: “bruja”. Aunque la estructura pueda ser la misma, X PERSONA es como BRUJA, pragmáticamente el sentido es opuesto, una es un halago: “me hechizaste de amor” y la otra es una ofensa: “eres horrible”.

La velocidad con la que se mueve Twitter implica que poder analizar sus discursos, que circulan ágil y dinámicamente, requieren de métodos igualmente ágiles. De hecho, el texto de Mancera y Pano (2013), aunque describe en gran detalle el funcionamiento de la plataforma, ya se ha desactualizado, en cuestión de relativamente pocos años, como pasa con muchos textos teóricos acerca de tecnologías contemporáneas. La plataforma ha transformado sus algoritmos, su interfaz, en incluso el límite de caracteres permitidos en los tweets. Para dar cuenta de esta agilidad, una estrategia clave para poder entender los discursos que circulan en twitter consiste en tomar muestras representativas o en hacer análisis automatizados que puedan resumir y generalizar los contenidos. De este modo, se hace uso de estrategias de anotación manual o ayudada por inteligencia artificial, o se usan estadísticas descriptivas como el conteo de frecuencias en grandes volúmenes de tweets, u otras estadísticas sumarias. Así, el análisis del discurso se ve ayudado por metodologías cuantitativas que permiten manejar grandes volúmenes y que enriquecen la lectura de los tweets que, por la propia lógica de la plataforma, son muy breves y escuetos (pero no por eso poco significativos).

Sin embargo, aquí cabe preguntarse si estos procesos rápidos y masivos podrían dar cuenta de los conceptos que ponen en juego las metáforas que usamos en la vida cotidiana, o que existen en expresiones retóricas como la propaganda política. Como dijimos, la metáfora no está en el texto sino en la cabeza de quien la interpreta, así que contar la frecuencia de aparición de ciertos términos le hace justicia realmente al significado de un discurso si no se matiza, como vimos con el doble sentido de “bruja”.

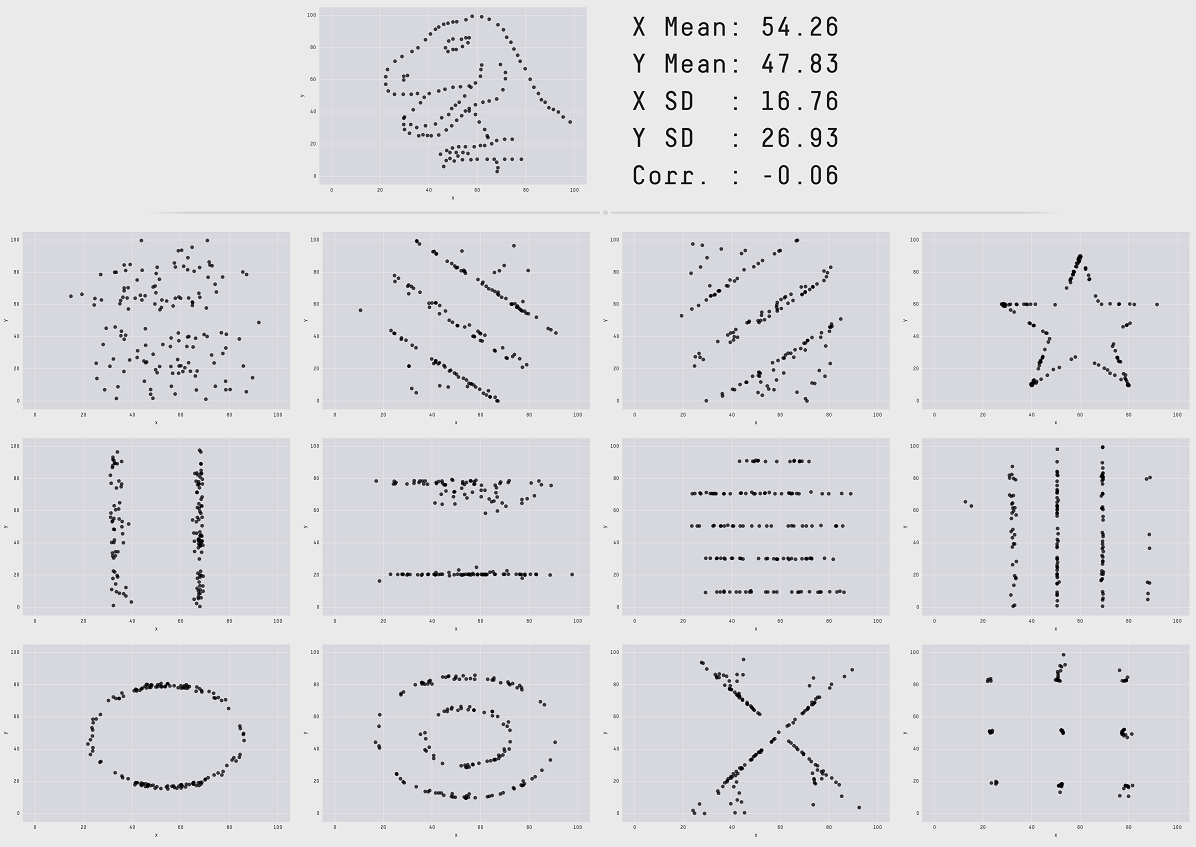

Los problemas de los resúmenes estadísticos descriptivos han sido estudiados ampliamente en el campo de la visualización de datos. Un caso concreto son las demostraciones juguetonas de (Cairo, 2019; Matejka & Fitzmaurice, 2017) en las que crean conjuntos de datos completamente diferentes que, analizados estadísticamente, tienen los mismos promedios, medias, desviaciones estándar y correlaciones. A través de esta demostración, los autores de estos ejercicios investigativos demuestran que, parafraseando a Cairo, “las estadísticas pueden mentir”. Así, una estadística sumaria puede tender a desinformar acerca del discurso, más que a permitir un entendimiento profundo.

Tal vez, para producir interpretaciones más cercanas a las mentes de las personas tendríamos que crear métodos automatizados y ágiles que se parezcan a las capacidades cognitivas que tenemos los humanos. Por ejemplo, algoritmos metafóricos que aprendan sus propios dominios y que puedan hacer proyecciones flexibles. Eso, como ha mostrado la inteligencia artificial, en sus relativos éxitos pero sus profundos fracasos, no es una tarea fácil. Siguiendo a Cairo, un análisis del discurso que no caiga en trampas estadísticas debería también poder dar cuenta de la ambigüedad y la inconsistencia, que son comunes en el discurso humano, que es fluctuante y contiene muchas minucias implícitas.

Referencias

Cairo, A. (2019). How charts lie: Getting smarter about visual information (First edition). W. W. Norton & Company.

Ibarretxe-Antuñano, I., & Valenzuela, J. (2012). Lingüística cognitiva. Anthropos.

Lakoff, G., & Johnson, M. (2015). Metáforas de la vida cotidiana. Cátedra.

Mancera Rueda, A., & Pano Alamán, A. (2013). El discurso político en Twitter: Análisis de mensajes que «trinan» (Primera edición). Anthropos.

Matejka, J., & Fitzmaurice, G. (2017). Same Stats, Different Graphs: Generating Datasets with Varied Appearance and Identical Statistics through Simulated Annealing. Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems, 1290-1294. https://doi.org/10.1145/3025453.3025912