Esto es una prueba

Category: Uncategorized

Hola mundo!

Bienvenidos al sitio web del curso Métodos Avanzados de Investigación 1 del Doctorado en Comunicación, Lenguajes e Información. Este es un espacio para construir comunidad de aprendizaje y crear y compartir conocimiento.

N-etnografía:

Métodos etnográficos en línea, comunidades virtuales y análisis de sentimientos.

Por: Luis Felipe Navarrete Echeverría

La conformación de ecosistemas mediáticos consolidados por la edificación de las infraestructuras y tecnologías digitales de la información y la comunicación, ha permitido la expansión, asentamiento y dinámicas particulares de comunidades en el ciberespacio. Este fenómeno ha fomentado la apertura de dimensiones de investigación; una de ellas es la aplicación de métodos etnográficos en línea, potente enfoque metodológico que permite generar elementos para la comprensión de las comunidades virtuales.

Esta ruta de trabajo investigativo sitúa la mirada sobre las particularidades de estos agentes, sus procesos, así como el trabajo sobre documento on-line así como la posibilidad de generar interacciones con estas comunidades. Desde lo señalado por Jörgen Rahm-Sâgeby, puede verse cómo desde allí se puede hacer seguimiento de las participaciones de los usuarios, las dinámicas y protocolos de intercambio de información y comunicación; procesos claves de este tipo de comunidades, estableciéndose cierta facilidad de registro, en tanto las actividades que ocurren en estos espacios, quedan registradas en estos soportes y permiten la recolección de datos; pueden registrarse “huellas” y actividades concretas y datos perdurables.

Debe señalarse que la etnografía o aplicación de métodos de esta orientación en comunidades en línea, tiende a centrarse en un enfoque cualitativo, puede potenciarse desde el uso de métodos computacionales (teniendo en cuenta la amplia cantidad de datos y las posibilidades brindadas por estas herramientas), que se adentran en las dinámicas de redes sociales digitales, permiten el rastreo de las formas de-ser en comunidad, su organización, caracterizar comportamientos y prácticas mediáticas. Puede resultar sumamente provechoso, enfocar esta perspectiva metodológica al seguimiento o la articulación del mundo on-line al of-line o lo que se referencia como “etnografía Interconectada” que permite (permitiría) mapear varios lugares, términos de uso y prácticas de interacción.

La propuesta de Sâgeby se concentra en la explicación de la realización de este tipo de etnografía, mostrando algunas de las similitudes con la etnografía tradicional, así como las formas de rastreo o recopilación. En términos estructurales, se señalan los siguientes momentos cómo claves en la elaboración y desarrollo:

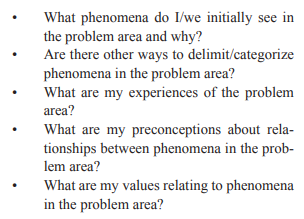

- Podemos hablar de la definición de entorno, del fenómeno, de la configuración y el enfoque. Aquí se sitúa la perspectiva de investigación, la historia (o historicidad como fenómeno continuo, inacabado, inclusive podemos agregar: hipertextual, reticular, interconectado), las características del entorno, los usuarios, contenidos…en una acción que se orienta a delimitar y describir. Las siguientes preguntas pueden dar orientaciones que ayudan a la precisión en este posicionamiento:

A su vez, debe precisar la modalidad de acción que tendrá el investigador: puede participar como espía (de manera incógnita, registrando, no interviniendo las prácticas y trabajado sobre perfiles o entornos públicos o abiertos); como miembro (por modos de relacionalidad de interés, por pertenencia al grupo, por agregación…) o declarando su posición como investigador de lo que allí ocurre. Esto hace necesario recurrir a elementos de habeas data y la consolidación inicial de una –no formal- declaración del lugar de enunciación-investigación, acompañando a su vez las implicaciones éticas del estudio.

- Seguiríamos con la recopilación de datos en línea, que se nutriría de la riqueza multimedial –en términos de lenguajes-formatos- que precisa el manejo o registro de imágenes, sonidos, la pregunta por ¿qué datos son significativos? ¿qué datos permiten precisar la comprensión? Se puede señalar una fuerte orientación hacia los datos de textuales. Aquí también se despliegan las materializaciones de forma de tomar los registros: procesos de inmersión, diarios de campo…

- Una vez realizada esta gestión, se continúa con el debido análisis de datos. si bien se puede apelar a diversas herramientas computacionales que permitan “la mirada del investigador”, se puntualizan procesos concretos como la mirada a las recurrencias, las concurrencias, que están acompañadas u orientadas por procesos de codificación e inclusive por los soportes que se tienen concernientes a categorías o enfoques teóricos.

Puede hablarse de una inter-etapa o etapa contingente que se situaría en la (retro) alimentación de información a la comunidad estudiada, concentrada en la adición de datos, la revisión de problemáticas, las –hipotéticas o parciales- soluciones a problemáticas…aspectos que dependen del grado de implicación del investigador, así como de la problemáticas desde la cual se edifica la investigación.

- Presentación de datos. Luego de las etapas anteriores, se precisa de la presentación de los resultados, que busca articular las cualidades del diseño digital con las proyecciones alcanzadas a –casi- manera de conclusiones, que se enfoca en la comprensión del fenómeno estudiado en estos entornos. Se busca la prevalencia de la perspectiva analítico-descriptiva.

No puede omitirse el hecho de que este tipo de investigaciones, al trabajar con agentes humanos, insertarse en relación a emociones, sentimientos, ideologías, rituales, prácticas de sentido… debe posicionarse en el ámbito de una ética de la investigación, que se sostiene desde la claridad, el manejo adecuado de la información, la transparencia con los resultados, las consecuencias de los resultados…una serie de acuerdos que deben inclusive entrar en negociación con las comunidades investigadas y ampararse inclusive en criterios normativos en aras de la transparencia o reconocimiento de principios.

El autor va a considerar algunas de las limitaciones y potenciales del enfoque etnográfico aplicado a comunidades en línea. Dentro de las primeras, se va a señalar: su representatividad: la volatilidad, fragmentación y pasos del online al off line, así como los sentidos de enlace o interacción, no van a permitir realizar grandes generalizaciones –inclusive la etnografía tradicionales reconoce y asume esta “imposibilidad”; a su vez el anonimato y las orientaciones tiene su implicación al momento de hablar de fiabilidad, pues se pueden realizar ajustes o “procesos de edición” sobre lo allí establecido. Otro elemento que interfiere en aquí es la existencia de bots, esas “máquinas de-lo falso” que inciden en los datos que se generan en estas comunidades. Ahora bien, respecto a la potencialidad de esta metodología esta la rigurosidad del rastreo, el trabajo interactivo con las comunidades, que puede abrir amplios márgenes para la comprensión del fenómeno, lo cual enriquece el valor heurístico de este tipo de investigaciones.

Una de las miradas concretas sobre enfoques o posibilidades de investigación en los Ciber-entornos está concretado en los “análisis de sentimientos” como el trabajo que presentan Pudarruth, Moheeputh, Permessur y Chaamroo, en el cual, utilizando la herramienta N’vivo 11 y la posibilidad de codificación automática, se centraron en un análisis de este tipo realizado a partir de los comentarios en Facebook.

En este trabajo se reconoce el poder exponencial de las redes sociales digitales y cómo el incremento en la cantidad de usuarios (por ejemplo en Facebook) y la gran cantidad de información que allí se comparte (que va desde información personal, religión, edad, status, estilo de vida, preferencias, ideología, valores, sentimientos). Los investigadores se centraron en el análisis de este tipo de data, que pasó de un registro inicial de comentarios, para luego hacer una categorización ente comentarios positivos, negativos y neutros a través de la función automática de N’vivo.

Los investigadores, antes de ahondar el desarrollo de su proceso, presentan un pequeño “estado del arte” en el cual se puede resaltar:

- Deben reconocerse las posibilidades de revisar conversaciones públicas en los muros, así como el reconocimiento de las configuraciones de privacidad, lo cual `puede concluir en una facilidad de registro o marcar limitaciones a accesos restringidos.

- En redes sociales digitales como Facebook, los usuarios están expresando las particularidades de su vida cotidiana, sus experiencias, sus amistades; acciones materializadas a través de mensajes, likes, publicaciones, comentarios, imágenes, tags…este tipo de contenidos permite acercarse a una caracterización de sentimientos que dan cuenta de los impactos en el pensamiento y el comportamiento. Palabras (o reacciones) se expresan en categorías como “feliz, triste, enojado, amor, odio…”

- Realizar análisis de sentimientos permite, a través de los comentarios y publicaciones, hacer caracterizaciones precisas sobre las actitudes de los usuarios frente a determinadas referencias. Esto se ha aprovechado por empresas que buscan hacer posicionamiento de mercancías, rastrear la percepción frente a nuevos productos, determinar la lealtad a la marca o el impacto de la reputación o la imagen. Lo fundamental es la codificación que permita precisar la tendencia de los sentimientos. Se han usado para esto algunos tipos de clasificadores como “Support Vector Machines (SVM) o Naïve Bayes”.

- El análisis de sentimiento ha resultado enriquecedor para revisar en términos generales el comportamiento humano frente a ciertas experiencias.

- La bibliografía e investigaciones sobre análisis de sentimientos ha venido en aumentos, tal como lo detectó el trabajo realizado por Sharef, midiendo el número de publicaciones –reg. Scopus- y señalando el incremento de trabajos en redes sociales como MySpace, Flicker, Twitter y Facebook.

- El trabajo de Ortigosa et al. Apeló a un enfoque hibrido que involucró léxicos y técnicas de aprendizaje automático, con el objetivo de extraer sentimiento de los mensajes y estados de Facebook, desde allí se ha buscado precisar la “personalidad” y precisión de los datos. en su aplicación y revisión sobre posibilidades de predicción fundamentada en los sentimientos, se señala que se puedo predecir la personalidad de unos 20000 usuarios, marcando una precisión del 62% desde la aplicación de su modelo de clasificación.

- El rastreo de interacciones y los niveles de sentimientos en las interacciones en facebook fue aordado por Terrana, marcando los temas, los perfiles con quien más se discute, los niveles de acuerdo y desacuerdo. Para esto se registró un análisis de sentimientos sobre 187 políticos después de las elecciones. A su vez Caton, entre otros, se centraron en el análisis de 1.9 millones de comentarios politicos para ver la percepción frente al pasado, presente y futuro. Una experiencia situada en MySpace, concluyó que los usuarios mujeres tienden a recibir y dar más comentarios positivos que usuarios hombres.

- Este tipo de análisis, situado en Twitter ha mostrado: Bae y Lee revisaron el efecto de las personas influyentes en sus seguidores, para comprender el impacto emocional en las audiencias; el trabajo de Pearce sobre los comentarios sobre el cambio climático precisa que las personas tienden a responder a personas que tienen las mismas inclinaciones de opinión, a su vez se ha estudiado la acogida de productos concretos especificando como la acogida emocional incide sobre el fracaso o éxito de los mismos…desde allí se han buscado fortalecer tecnologías para el rastreo y registro.

- El grupo de Losub investigó la colaboración en Wikipedia y encontró que las emociones esta articuladas con características como status y género.

- Se han estudiado las percepciones de los turistas en la fuente de TripAdvisor, revisando la incidencia de las opiniones sobre las decisiones.

- Autores como Gopladas hablan de la imprecisión, inexactitud y limitaciones que se dan en las conclusiones en este tipo de análisis.

Ya situados en el trabajo de Pudarruth et al. Se concreta un análisis sobre las emociones detectadas en publicaciones y comentarios de una pag. De Facebook (Opiniones opuestas 2016), utilizando el software Nvivo 11 para el manejo de datos no estructurados, así como el complemento Ncapture. Para la clasificación (positivo-negativo-neutro) se realizó inicialmente un proceso de limpieza de datos –pues aparecen muchos metadatos- . Se revisaron las cadenas, para pasar a su revisión individual en un proceso de división (tokenización), pasando luego a la revisión de las derivaciones, dadas las múltiples formas o raíces de las palabras en inglés que aparecían en la muestra y podían facilitar la precisión (ejemplo: analizar, análisis, analiza…

Seguido a esto, se aprovechó el uso de Nvivo para el manejo de sinónimos o palabras similares (miedo: temor, pavor, asombro…). Esto se proyectaba al paso de la clasificación, para lo cual se continuó con el codificador automático de la aplicación usada, pasando inclusive a regulaciones como: positivo, muy positivo, negativo, moderadamente negativo; proceso que requería la revisión de los modificadores –adverbios-.

Los investigadores encontraron que de una totalidad de 626: 215 se han codificado como muy negativos, 173 como moderadamente negativos, 110 como moderadamente positivos y 75 como muy positivos. Los comentarios que no están codificados en estas cuatro categorías se consideran neutrales.

Nvivo se sitúa para esta clasificación en el análisis de palabras aisladas y permite una mirada panorámica y rápida sobre los datos, en tanto facilita la carga de data, el procedimiento sobre el codificador y los procesos de graficación. Esto permitió al equipo trabajar sobre datos textuales y señalar que se puede revisar el uso de expresiones en redes sociales para establecer precepciones; acción recomendada a empresas para escuchar los modos de apropiación del mercado desde los usuarios, diseñar estrategias, evaluar opiniones y mejorar la oferta de manera o desde referencias concretas.

Los investigadores señala además que la herramienta N’vivo 11, si bien es potente, no permite tomar el análisis de todo el comentario –pues se hace palabra por palabra- , además, como otra de sus limitaciones, está en que no tiene en cuenta el contexto, no reconoce jergas, regionalismos, modismos, neologismos ni sarcasmos. Esta investigación reconoce, no trabajo con las imágenes y otros elementos que aparecían allí (como enlaces), componentes que permitirían mejores niveles de especificidad.

La codificación en el método de investigación de la grounded theory o teoría fundamentada (Virginia Monge Acuña)

La teoría fundamentada se concentra en la posibilidad de crear marcos teóricos o conceptuales, a través del análisis y la conceptualización que emerge, si o si, de la codificación de los datos. Debe destacarse que la teoría fundamentada se entiende tanto como método de investigación así como la teoría resultante de la aplicación:

Si bien la teoría fundamenta puede operar sobre-desde datos cuantitativos o mixtos, puede evidenciarse una preferencia por datos cualitativos. En términos metodológicos el proceso central es la codificación.

En el desarrollo de la teoría fundamentada se requiere, durante los procesos de codificación, la escritura de memos y actividades de comparación, lo cual permitirá ir develando relaciones de manera constante. El proceso implica la estructura de revisión “código con código-código con categoría- código con nuevos datos- código con memos” en una dinámica que permite, inclusive, volver a la población, en busca de responder cuestionamientos que se plantean durante esta acción.

La escritura de memorandos implica-permite:

- Establecer de manera constante anotaciones que surgen sobre los códigos y categorías –emergentes- a manera de observación del investigador.

- Se considera relevante en esta –y diversas- metodologías de investigación, en tanto permiten ensanchar la comprensión de los problemas abordados.

- Pueden usarse registros escritos o grabaciones: permiten hacer memoria del proceso, así como matizaje de las comparaciones y contrastes de los datos.

- Pueden implicar registros extensos, así como –y quizá mejor y más práctico- notas, tags, frases, ideas, etc.

- Se recomienda establecerse desde una lógica sistemática y estructural “de acuerdo con los códigos, categorías y combinaciones emergentes”

Estos procedimientos precisan de una concreción de los procesos de codificación que permiten resaltar:

- Es “proceso sistemático y riguroso de análisis y conceptualización por medio del cual se aplican procedimientos y estrategias que culminan con el surgimiento de una categoría central cuya caracterización va a ser expresada en términos de una teoría emergente”

- Muchos códigos suelen “aumentar su densidad” pasando a constituirse como categorías. La categoría de mayor concentración y que permite la relación del cuerpo de categorías pasaría a ser la categoría central o nuclear.

- Aparecen los conceptos como “representaciones abstractas –ideas, pensamientos verbalizados, formas de entendimiento, juicios, opiniones– ya sea de acciones, eventos, interacciones, experiencias, expresiones y manifestaciones que las personas investigadoras identifican como revelaciones de carácter significativo en los datos” , los cuales son codificados y permitirán la edificación explicativa sobre el fenómeno que se investiga.

- El proceso de codificación sugiere el siguiente procedimiento, que desembocaría en la proyección de la construcción o constitución emergente de la teoría:

Uno de los procedimientos posibles, como se había señalado, es la codificación sustantiva:

- Se inicia con el proceso de codificación a partir de “fragmentos textuales”. Estos pueden mostrar una “relación abstracta” entre participantes y datos generados.

- Los códigos, en su crecimiento y fijación, irán tornándose en categorías y de categorías generales a centrales o nucleares. Permitirán proyectar una explicación teórica.

- “integra significados” desde los datos , proceso que requiere la comparación de los “códigos iniciales” con los “códigos posteriores”, lo cual permite ir puliendo la categoría central o nuclear.

- “se propone conceptualizar lo esencial en los incidentes evidenciados en los datos”.

- La codificación es sustantiva cuando la fragmentación de los datos se presenta en vivo o “expresados en otras palabras en las etapas de análisis iniciales”. Se busca permitir un mejor reconocimiento de los datos, proceso comunicativo que valida su uso, pues son los participantes los que entrarían a “legitimar” la validez, así como contribuir a rescatar aspectos que pueden pasar desapercibidos.

- Se emplean los procesos de codificación abierta y selectiva:

- Se precisa de una comparación y contraste de significados y relaciones

- Se compara: código con código-código con categoría- código con nuevos datos. (esta acción puede requerir volver sobre la población para responder a cuestionamientos “emergentes”)

- Se precisa la escritura de memos: anotaciones sobre los códigos y las categorías, así como de ideas generales, preguntas y observaciones.

Otro de los procedimientos posibles es la codificación teórica. Frente a esta puede señalarse:

- Busca la “saturación teórica” como etapa situada en el momento en que desde las categorías no aparecen propiedades nuevas.

- Alcanzar esta etapa, permite la constitución de los “códigos teóricos” o los que serían las categorías centrales.

- La articulación conceptual de los códigos es el objetivo de esta ruta

- Los códigos de tipo teórico son o funcionan como “delimitadores abstractos de conceptos esenciales que explican la categoría central”

- Permite o proporciona el andamiaje desde el cual se estructura y finiquita el marco teórico.

- Al igual que la codificación sustantiva, requiere de comparación y contraste constante, así como de la escritura de memos. La diferencia es que aquí el propósito no es tanto descriptivo sino más analítico y de abstracción. Para fortificar este proceso resulta vital el establecimiento –y ojeada constante- de los antecedentes.

Puede entonces concretarse, en relación a los procesos de codificación:

La teoría fundamentada exige y provee rigurosidad, es sistemática y a su vez, flexible. Su alcance es potente y permite explorar explicaciones a diversos y ampliados fenómenos. Sus soportes son “hermenéuticos y dialécticos”, en procesos que fomentan el diálogo con las poblaciones sujetos de investigación. A demás permite, metodológicamente, orientaciones de tipo cuantitativo, cualitativo y/ o mixtos.

Ética en la investigación cualitativa – ACastiblanco MMCorral

Por Amanda Castiblanco y Maria Mercedes Corral

La presente reseña tiene como fin encontrar los puntos claves y críticos de los artículos propuestos en torno a la ética de la investigación. Estos abordan temas centrales de significado de la investigación cualitativa y desde allí desprenden el enlace directo con los métodos computacionales, las tecnologías y el internet.

Finalmente, se propone una aproximación hacia las conclusiones que emergen del enlace entre investigación cualitativa y ética de la investigación a partir de los artículos.

1. Aspectos éticos de la investigación cualitativa

La investigación cualitativa, es por predilección un campo metodológico utilizado para descubrir, desarrollar, investigar y profundizar problemas y contextos sociales, bajo una mirada subjetiva. De antemano, en discusión epistemológica, se registra la fuerte disputa por la inclusión y reconocimiento como ciencia mantenida durante siglos, la cual, se ciñe a legados positivistas que plasman el ideal de ciencia desde su capacidad de comprobación.

El valor de las ciencias del espíritu cuyo foco se centra en las humanidades, enfatizando el enlace con los contextos socioculturales, es percibido desde la observación de problemas que van más allá de la experimentación cerrada, específica y directa, cuyos resultados no se pueden plantear en una hipótesis que reclame sesgos en el proceso finalizado de cualquier investigación. Al partir de interpretaciones subjetivas, se corresponde con interpretaciones y argumentaciones de los actores participantes del proceso.

Lo anterior permite discutir la investigación cualitativa como un campo de ciencia que puede ser observada éticamente; desde allí se preocupa por las realidades contextuales, sociales, tanto humanas como no humanas, que asienten su mirada crítica de validación del otro y de lo otro. En este sentido, se debe reconocer en las formas diversas de entender el mundo, la sociedad, la naturaleza y sus transformaciones bajo otras miradas y perspectivas.

Con base en estudios cualitativos, la ética de investigación permite cuestionar la parcialidad científica, que, según González (2002) plantea resultados enlazados holísticamente, con los actores y el objeto de la investigación, descubriendo históricamente que “la objetividad de la ciencia fue vista de otra manera desde que comprendimos la carga teórica de la observación, la infradeterminación y las limitaciones de los estudios inductivos” (González, 2002, p. 86) lo que permite cuestionar en práctica e interacción dicha objetividad.

Lo anterior entabla relaciones de apertura hacia otros escenarios, que según las herramientas computacionales pueden enfocar los resultados de una manera un poco más objetiva. El enlace de la investigación cualitativa con las tecnologías debe cumplir con las siguientes características como cualquier estudio etnográfico:

Tradiciones: argumentadas teóricamente

Aceptación social: del conocimiento producido

Correspondencia de elementos objetivos – subjetivos

Estos elementos permiten mantener el ideal de la ciencia sustentado en que, según González, “tanto el conocimiento, como las metodologías creadas y la experiencia derivada del ejercicio de la ciencia son productos culturales” (González, 2002, p. 89) que pueden construir procesos de investigación con desarrollo tecnológico permitiendo mejorar la calidad de vida desde las mismas comunidades.

El vínculo entre ciencia y tecnología optimiza la construcción de pensamiento crítico que repiensa las formas de hacer ciencia acercando la discusión a fenómenos sociales. Lo anterior se apoya en la ética de la investigación cualitativa que, según González (2002) se fundamenta en que:

- El conocimiento es una producción constructiva e interpretativa

- El proceso de producción del conocimiento en la psicología y las ciencias sociales es interactivo

- La significación de la singularidad tiene un nivel legítimo en la población del conocimiento

Pero ¿qué características surgen en la ética de la investigación cualitativa? Como lo menciona el autor, son las mismas que en la investigación cuantitativa. Sin embargo, se suman elementos que constituyen al sujeto o investigado bajo elementos de respeto y veracidad. Por tanto, se basa en reconocer la subjetividad del individuo que lo comprende como ser único, el cual, acusa un papel fundamental en el diseño, implementación, proceso y resultados de la investigación.

Lo anterior plantea la necesidad de reconocer las diversidades éticas de la investigación, así como conocimiento científico, para poder ajustarlas al proceso real, generando diálogo constante que mantenga en buen estado el proceso y finalmente observar al detalle elementos éticos evaluables que según González se describen desde:

- Validez científica: que mantenga la sincronía entre teoría, métodos, herramientas que legitiman una información

- Valor social o científico: que proponga o mantenga beneficios, bien sea individuales y/o colectivos

- Selección equitativa de los sujetos: mantiene características científicas que argumentan el estudio y se pueden beneficiar en doble vía

- Proporción favorable de riesgo – beneficios: Minimizar el riesgo es igual que maximizar beneficios para los investigados

- Condiciones de dialogo auténtico: natural, que defienda posiciones ético-político-sociales en beneficio de un colectivo que reconoce las voces afectadas dialógicamente

- Evaluación independiente: realizar evaluación externa de investigadores, pero manteniendo el reconocimiento de autoridades investigativas

- Consentimiento informado: Solicita participación y por supuesto consentimiento de los procesos de investigación

- Respeto a los sujetos inscritos: que contemple los diversos escenarios en donde se pueda irrespetar la participación, el consentimiento, el cambio en la dirección de la investigación, la devolución y muestra de resultados y todo aquello que emerja del proceso.

2. Ética en la investigación cualitativa sobre comunidades de internet

¿Qué es internet para la ética en la investigación cualitativa?

Considerando que internet se puede ver como el mayor repositorio de material que hoy se tiene, y donde todas las personas entregan allí sus opiniones, gustos, comentarios, por referirnos a algunos elementos. El análisis cualitativo de todos estos datos e información puede servir para entender y conocer preocupaciones, necesidades, gustos de personas y también para temas más relevantes como la salud. Sin embargo, la investigación plantea otros aspectos de ética, frente a las personas que serán los sujetos de investigación, y de quienes se debe solicitar su consentimiento para participar en una investigación, como se menciona en el artículo de Eysenbach, et al, (2001), estas fronteras entre lo público y lo privado se difuminan en internet. Los consentimientos informados son necesarios para estos procesos y adicionalmente dado que en internet se conforman comunidades de personas a través de los websites, listas, grupos ente otros, los cuales generan comunicación entre ellos y es necesario en el momento de requerir participación contar con su aprobación. Existen varios ejemplos, entre estos los relacionados con información de salud.

La investigación cualitativa cuenta con información de publicaciones en internet, donde se tienen las voces de las personas, como lo menciona Eysenbach, et al, (2001), en esta investigación existen tres tipos de métodos con base en Internet, el primero en un análisis pasivo, como se tiene en estudios que se encuentran publicados o grupos de interacción sin contar con la interacción propia de los investigadores, otro tipo de investigación tiene en cuenta participación más activa y comunicativa de los investigadores quienes revisan la información recolectada y buscan la precisión de las respuestas. El tercer método, ya cuenta con la identificación de los investigadores y éstos recolectan la información a través de entrevistas, encuestas y así mismo a través de internet buscan quienes participen de su investigación. Es importante tener presente que las comunidades de internet pueden eventualmente ver los investigadores como intrusos en sus temas de comunidad más allá de ver la investigación misma, este tema se empieza a manejar en internet con los elementos relacionados con la privacidad y confidencialidad de los datos.

Como principios éticos de la investigación científica se tiene la privacidad, confidencialidad y el consentimiento previamente informado Eysenbach, et al, (2001), para entender si en internet se requiere el consentimiento informado, se debe primero conocer si las comunicaciones dentro de la comunidad son públicas o privadas, puesto que si la información se está tomando en un espacio privado se requiere que las personas autoricen el utilizar su información. En internet es importante tener en cuenta las medidas sobre la privacidad, esquemas de registro y autorización, tamaño de los grupos y otro elemento son las normas que se definan en el grupo y el tipo de preguntas que se hacen.

3. La ética en la investigación cualitativa: una visión del mundo de los participantes y los investigadores desde un punto de vista crítico.

Es de entender que la investigación en internet se da gracias a que los investigadores cuentan con una serie de participantes que están allí, sin embargo, lo más importante es tener claro cómo se llega a ese grupo de personas /participantes, y aquí entra como aspecto clave los diversos conflictos éticos que se pueden presentar. (Orb et al., 2001).

Así mismo es importante tener en cuenta si el investigador tiene algún conflicto de interés con el grupo de participantes, por alguna relación que exista con este grupo de personas, en cuyo caso también hay que tener presente las normas éticas. Otros casos se dan por ejemplo cuando se quieren compartir fotos, o estas hacen parte de la investigación.

Los métodos de invitar a la participación deben ser tan claros que los participantes no se sientan coaccionados y que el tratamiento a las personas no puede depender de si se participa o no en la investigación. Un punto que resalta es también el grupo social al que se quiere llegar, entendiendo que pueden ser grupos o comunidades vulnerables, que no tienen elementos de claridad sobre el tema, no sobre el uso de las tecnologías inmersas en la investigación. El Código de Nuremberg de 1947 indica que el consentimiento voluntario del sujeto humano es absolutamente necesario (Ghooi, 2011), lo cual también sugiere que no solo se está protegiendo a la persona sino también, existe una responsabilidad social desde la investigación, (Schwandt, 2007). Por lo tanto el grupo social y sus condiciones hacen parte de esta responsabilidad.

De la misma manera es importante para los investigadores que puedan tener algún tipo de protección contra daños personales o en su núcleo social; y así mismo considerar las estrategias que se pueden adoptar para evitar los riesgos y dificultades que se presenten durante la investigación (Dickson-Swift et al., 2008). Existen las instancias de las Juntas para la Ética en la investigación, quienes tienen responsabilidad de garantizar que los investigadores consideren el bienestar de sus participantes y minimizar los daños por riesgos que emerjan durante el proceso.

Al realizar investigación cualitativa se debe tener en cuenta el concepto de conciencia crítica de la ética, concepto que va más allá de procedimientos y principios y llega hasta la toma de decisión ética. (Dilmi, 2012). ¿Cómo se aprende esta conciencia crítica para la investigación ética? Este es un proceso que involucra, diálogo, temas escritos, visuales, y un grupo de personas de diferentes culturas, educación. (Denzin & Giardina, 2007; Keith-Spiegel, et al, 2002; Kumagai & Lypson, 2009), sin embargo, no es un concepto que debe inmovilizar la investigación ya quienes tomen decisiones, debe proveer más bien elementos para lograr mejores preguntas y reflexiones sobre lo que se está encontrando en la investigación. El aprendizaje de la conciencia crítica requiere recursos y necesariamente una flexibilidad ante la escucha, el diálogo, el cuestionamiento. Se debe invertir en aprender de esta mentalidad crítica y reflexiva lo cual ayudará a construir esos investigadores con conciencia crítica. (Dilmi, 2012).

4. Aproximaciones de la ética en investigación cualitativa

La investigación cualitativa es un medio para explorar y capturar las experiencias subjetivas de las personas, sin embargo, puede llevar a desafíos éticos para las dos partes, los investigadores y los participantes.

Uno de los desafíos que debe ser observado con detenimiento es el reconocimiento de los actores participantes del proceso en relaciones no jerárquicas, lo cual permite desarrollar la investigación de forma natural. De esta forma, se puede responder a la problemática atendida, en un escenario tradicional, propio lejos de transformaciones acomodadas. Esto a su vez, asegura una interacción transparente que puede encontrar su foco en aspectos culturales, sociales y cotidianos, con alto grado de rigor social y por supuesto, metodológico.

Por otro lado, y quizás el más importante que se debe revisar constantemente, es la dirección de los resultados. Si bien, la investigación cualitativa es planteada con el fin de descubrir realidades sociales, es a esas mismas realidades a las que se debe enfocar el estudio. Es decir, centrar la investigación en resultados, que más que responder al escenario académico, en lo mayoría de estudios, sea una respuesta y/o un aporte comunitario.

A su vez, cada escenario debe mantener el consentimiento informado del proceso y la devolución, teniendo en cuenta que esta última no es una mera muestra de resultados sin sentido, o que puedan ser explotados fuera de la comunidad. Al contrario, deben ser consensuados y en lo posible, que puedan ser usados por ellos mismos en escenarios de extensión de la investigación y/o como una base de muestra comunitaria.

Para el caso de las Investigaciones cualitativas utilizando internet, es importante poder separar los escenarios públicos y los privados, así como definir quienes pueden ser esos participantes de cada uno de los espacios. Lo anterior apoya el protocolo construido en torno a los procesos de recolección de datos anidado al contexto.

Finalmente se debe reflexionar que estos trabajos de orden social exigen responsabilidad social y a la vez la conciencia crítica puede proyectar la realidad, lo cual puede generar valor y beneficio a la sociedad, en la medida en que se puedan conocer determinados resultados. Lo anterior requiere entender que la relación mencionada, compaginada con el investigador y los participantes genera experiencias totalmente subjetivas, donde las voces de personas, sujetos, objetos, tradiciones y cotidianidades, recrea y dinamiza los espacios socioculturales y políticos. (Dilmi, 2012) donde se actúa con un fin decidido. Desde allí, también se pueden entrever los riesgos de la investigación que se filtran desde el comportamiento ético de la investigación y la congruencia y compresión de actores, bien sea participantes, investigadores, elementos, entre otros.

Bibliografía

Dilmi, Aluwihare-Samaranayake. (2012). Ethics in Qualitative Research: A View of the Participants’ and Researchers’ World from a Critical Standpoint. International Journal of Qualitative Methods. 11. 64-81. https://www.researchgate.net/publication/233708898_Ethics_in_Qualitative_Research_A_View_of_the_Participants’_and_Researchers’_World_from_a_Critical_Standpoint

Dickson-Swift, V., James, E.L., Kippen, S., & Liamputtong, P. (2008). Risk to researchers in qualitative research on sensitive topics: Issues and strategies. Qualitative Health Research, 18, 133-144.

Eysenbach, Gunther & Till, James E.. (2001). Ethical issues in qualitative research on Internet communities. BMJ (Clinical research ed.). 323. 1103-5. https://www.researchgate.net/publication/11652275_Ethical_issues_in_qualitative_research_on_Internet_communities

González Ávila, M. (2002). Aspectos éticos de la investigación cualitativa. Revista Iberoamericana De Educación, 29, 85-103. https://doi.org/10.35362/rie290952

Ghooi, R.B. (2011). The Nuremberg Code-A critique. Perspectives in Clinical Research, 2(2), April-June, 72-76.

Kumagai, A.K., & Lipson, M.L. (2009). Beyond cultural competence: Critical consciousness, social justice, and multicultural education. Academic Medicine, 84(6), 782-787.

Orb, A., Eisenhauer, L., & Wynaden, D. (2001). Ethics in qualitative research. Journal of Nursing Scholarship, 33(1), 93-96.

Schwandt, T.A. (2007). The pressing need for ethical education: A commentary on the growing IRB controversy. In In N.K. Denzin and M.D. Giardina (Eds.), Decolonizing and politics of knowledge: Ethical futures in qualitative research. Walnut Creek, California: Left Coast Press.

El escenario de la investigación cualitativa basada en entrevistas en construcción de Teoría Fundamentada

La investigación cualitativa, como forma de comprender fenómenos, eventos y acciones, entre otras, que van más allá de la segmentación cuantificablemente, permite encontrar dentro de sí lecturas que acerquen la mirada al desenvolvimiento del humano desde su ser social; esta “rechaza la pretensión racional de solo cuantificar la realidad humana, en cambio da importancia al contexto, a la función y al significado de los actos humanos, valora la realidad como es vivida y percibida, con las ideas, sentimientos y motivaciones”(Mesías, 2010: s.p.) lo que en definitiva centra su atención en los sujetos que pertenecen y/o que hacen parte de la investigación.

Según Hernández (2014), esta metodología de investigación pone su foco de atención en tres escenarios teóricos que son: interaccionismo simbólico, recurre a formas de accionar el significado simbólico en las relaciones y sus interacciones; la etnometodología, que pretende acercar un estudio a la generación de cotidianidades en núcleo específico; y el estructuralista psicoanalítico, surge de la observación de procesos inconscientes que guardan relación con la interacción presentada.

Por otro lado, requiere afinar las características que vinculan la investigación hacia entornos de cualificación, los cuales según Hernández (2014) maneja intereses de experiencias y entorno natural, es decir, que se tejen en escenarios propios de los actores intervinientes; no parten de hipótesis, es decir, su actuación no inicia desde una base que atisba resultados, sino que desde la experiencia y el propio camino de investigación se construyen y tejen; y por otro lado permiten adaptar métodos y teorías a lo que va surgiendo en la investigación, lo cual empata con la necesidad de no plantear hipótesis.

Así mismo, se debe reconocer elementos claves, que como lo plantea Hernández (2014) permiten el buen desarrollo y fin del proceso, lo que sugiere que la investigación cualitativa parte de:

- Subjetividades del investigador

- Abordaje paradigmático

- Diseño de investigación

- Recolección de datos

- Construcción desde la interpretación

Lo anterior plantea escenarios diversos cualificables que se dirigen a formas de sustentar los resultados adyacentes. Uno de ellos es el resultado que se pretende acercar desde le interaccionismo simbólico, que, para el caso de la Teoría Fundamentada, es considerado como base y muestra de la interacción de diversos elementos hallados en el campo de la investigación.

La teoría fundamentada, como lo enuncia Charmaz (2006) permite explorar datos e ideas desde la mirada y escritura crítica y analítica inicial, que propone construir nueva teoría que emerja de los datos recopilados, es decir surge de la abstracción de esos datos que se categorizan en códigos que finalmente son utilizados para la construcción. El puente entre datos y teoría será planteado desde la codificación, la cual puede ser:

Abierta: que enlista los códigos y/o las categorías

Axial: que decanta las categorías de la codificación abierta y las subdivide en relación con las propias categorías

Selectiva: que selecciona un fenómeno central susceptible de interpretación.

Esta categorización da la apertura a la interpretación holística que parte de los códigos presentados, los cuales, siguen procedimientos de análisis y conceptualización que, en un siguiente escenario, representan la teoría nueva. La condensación de criterios de selección definidos, los cuales, en su momento de repetición, no evidencie aumento o complemento teórico, se convierte en saturación teórica, es decir alimento para la teoría formal (Morales, 2015).

Finalmente, un punto de reconocimiento para hacer teoría fundamentada es dado desde las entrevistas, las cuales, como lo enuncia Diaz et al (2013) son un instrumento de información y precisión que mantienen su sentido en la interpretación dialógica construida con el entrevistado. Se realiza con un fin determinado que pretende develar a profundidad elementos que sustentes la investigación bajo la mirada de los actores involucrados.

El punto álgido de esta herramienta se da en la interpretación que surge del testimonio y que como lo nombra Diaz, et al (2013) triangula la interacción teórica, con la información documental y los testimonios, en resultado, validan la nueva teoría. Sin embargo, hay un punto clave en la construcción de esta teoría, y tiene que ver con las interpretaciones que surgen constantemente desde la codificación.

Este último proceso recopila información de las observaciones y eventos surgidos que describen la codificación; se trata de los memorandos o memos, los cuales, permiten encontrar en la información, en los códigos y en el proceso, la mirada propia que surge al enfrentamiento con los datos. De esta forma, se combinan datos, memos, códigos, proceso y todos los elementos que surgen en la investigación, que se conjugan para emitir resultados de esta.

Bibliografía

Charmaz, K. (2006), Ch.1. ‘Invitation to Grounded Theory’ y Ch.3. ‘Coding in Grounded Theory Practice. Recuperado de: http://www.sxf.uevora.pt/wpcontent/uploads/2013/03/Charmaz_2006.pdf

Díaz-Bravo, Laura, Torruco-García, Uri, Martínez-Hernández, Mildred, & Varela-Ruiz, Margarita. (2013). La entrevista, recurso flexible y dinámico. Investigación en educación médica, 2(7), 162-167. Recuperado en 23 de julio de 2020, de http://www.scielo.org.mx/scielo.php?script=sci_arttext&pid=S2007-50572013000300009&lng=es&tlng=es.

Hernández Carrera, M. (2014) La investigación cualitativa a través de entrevistas: Su análisis mediante la teoría fundamentada. Cuestiones pedagógicas: Revista de ciencias de la educación, ISSN 0213-1269, ISSN-e 2253-8275, Nº. 23, 2014, págs. 187-210 Recuperado de: https://dialnet.unirioja.es/servlet/articulo?codigo=4909706

Mesías, O. (2010). La investigación cualitativa. Universidad Central de Venezuela.

Morales (2015) La teoría fundamentada (Grounded Theory), metodología cualitativa de investigación científica. Revista científica Pensamiento y Gestión, N°39: Jul – Dic 2015

Wolfinger, Nicholas. (2002). On Writing Fieldnotes: Collection Strategies and Background Expectancies. Qualitative Research – QUAL RES. 2. 85-93. Recuperado de: https://www.researchgate.net/publication/237968317_On_Writing_Fieldnotes_Collection_Strategies_and_Background_Expectancies/citation/download

Análisis de sentimientos de comentarios de Facebook y Métodos etnográficos en línea

Análisis de sentimientos de comentarios de Facebook usando codificación automática en NVivo 11 de Pudaruth et. al. y Métodos etnográficos en línea: Hacia una comprensión cualitativa de las prácticas de la comunidad virtual de Jörgen Rahm – Skageby

Por: Henry Romero

En esta reseña se refiere en primer lugar al artículo de Pudaruth, Moheeputh, Permessur, & Chamroo (2018) sobre análisis de sentimientos a través de Nvivo 11 y luego se abordará el artículo sobre Métodos Etnográficos en línea de Rahm – Skageby (2011). Para los dos textos se hará una descripción de los aspectos de mayor relevancia y del mismo modo se ofrecerán algunos juicios críticos alrededor de los mismos cuando se considere pertinente.

El análisis de sentimientos descrito se centra en los datos derivados de la red social Facebook, la que cuenta con la mayor cantidad de suscriptores en el mundo y en la que a través de la interacción con los perfiles, con funciones como like, clics, comentarios, mensajes, publicaciones, etc, ponen de manifiesto de manera escrita en palabras y símbolos sentimientos y emociones de los interactuantes.

De este modo y a través del uso de Ncapture dentro del software de análisis cualitativo NVivo se capturan 626 publicaciones y comentarios de usuarios de Facebook en el marco de la página de debates Opposing Views. Con esta muestra de datos se depuraron para clasificarlas como expresiones que reflejan sentimientos positivos, neutrales y negativos. En el análisis de los comentarios se clasificaron y codificaron los sentimientos como moderadamente positivos, muy positivos, moderadamente negativos y muy negativos. A cada codificación de estas se agruparon las palabras que transmiten sentimientos positivos y negativos con sus respectivos sinónimos. Se empleó el codificador automático que por solamente contar palabras sin contexto puede tener grandes limitaciones. Frente a los resultados se puede describir solamente que se obtuvo un 29.6% de comentarios positivos y un 62% negativos.

Más allá de lo cuantitativo, la utilidad de estos análisis redunda en los usos estratégicos de mercadeo empresarial que si bien no son una fotografía exacta de la realidad, sí permiten observar percepciones frente a asuntos y temas muy puntuales, como la manera con la cual se ha recibido un producto por parte de los consumidores.

El ejercicio descrito es significativo para comprender la funcionalidad del software NVivo y sobre el supuesto de que con las palabras expresamos sentimientos podemos indicar que hay importantes limitaciones. Una de estas en el grado de intensidad de los sentimientos que una sola palabra no puede reflejar, por lo que se requiere de un conjunto y contexto. De igual modo los contextos en los cuales se emiten los comentarios deben ser comprendidos, pues expresiones en distintos contextos pueden significar cosas distintas.

En segundo lugar se analiza el uso de métodos etnográficos en línea, que como sostiene Rahm-Skageby (2011) representa un recurso importante para abordar problemas en comunidades virtuales. El punto de partida es el reconocimiento de comunidades virtuales en las que hay un intercambio comunicativo permanente que sirve de base para identificar relaciones, problemas, interacciones motivadas, intereses, comportamientos, lenguaje simbólico, etc., material rico por su perdurabilidad en las tecnologías on-line, que es propicio a su vez para hacer trabajo de tipo etnográfico guardando las distancias con respecto a las comunidades reales y a la etnografía más tradicional.

Las similitudes son suficientes como para poder tipificar este enfoque de investigación cualitativa como etnográfico pero en comunidades virtuales y cuyo propósito según Rham-Skageby (2011) es mirar más allá de las cantidades y las distribuciones de datos y tratar de descubrir las razones más profundas de los comportamientos o sentimientos estableciendo sus porqués. Es así como en el artículo se exponen las etapas a seguir en un ejercicio etnográfico en comunidades virtuales.

En primer término se recomienda la definición del entorno y del enfoque de la investigación. En tato investigación cualitativa resulta importante el grado de participación del investigador y el punto de partida que este asume y cómo interpreta el entorno en el que se encuentra inmersa su comunidad objeto de análisis. El entorno, sostiene Rham-Skageby (2011), debe definirse en términos tanto sociales como técnicos, ilustrando, características típicas, procesos de desarrollo del sistema, base de usuarios, antecedentes históricos, fenómenos sociales característicos, contenido de importancia en las preguntas frecuentes, cualquier estándar oficial de conducta, etc. del mismo modo resulta útil para reconocer inicialmente la perspectiva de investigación como una forma de delimitar que las descripciones puramente objetivas y libres de valores son muy difíciles, si no imposibles.(Pág. 412)

El primer paso es hacer una entrada cultural a la comunidad, la cual puede ser oculta a manera de espía o abierta en donde se ingresa como un miembro más de la comunidad, presentándose como investigador y pidiendo consentimiento a los demás miembros. Luego de esta etapa se procede a la recolección de los datos en línea, la cual puede hacerse como recopilación de documentos, observación en línea o entrevistas en línea. Al ser de interés todas las actividades de la comunidad una clasificación de los datos puede ser pertinente, pues a pesar de estar direccionada por una pregunta de investigación los datos pueden ser más o menos pertinentes, por tanto siempre habrá riesgo en la selección. De igual modo se puede dirigir la recolección hacia una selección puntual sobre el objeto de interés o una distribución en la medida que se obtiene de diferentes fuentes en términos generales.

Como etapa subsecuente se hace una observación o una inmersión en la comunidad con el ánimo de poder comprender las actividades e interacciones en la comunidad haciendo un esfuerzo por experimentar la vida cotidiana tal como está compuesta por los miembros regulares de la comunidad estudiada. Esta participación en la comunidad varía en grado de involucramiento desde lo más abierto a lo oculto. Con la observación en línea y el apoyo de notas de campo se busca recoger con una mayor sensibilidad a los fenómenos datos e información de relevancia que no pueden deducirse únicamente del texto.

Las consideraciones éticas como etapa en el enfoque etnográfico en línea tienen el mismo valor que en la postura tradicional pues no siempre la información y datos son considerados públicos, por lo tanto se requiere de un consentimiento para su uso y de no ser así se debe optar por un uso que refiera al anonimato.

El análisis de los datos es una etapa fundamental que puede asumir diferentes modalidades dependiendo del tipo de problema que se esté abordando. Aun así, el análisis temático se remite a una lectura cuidadosa y una relectura de los datos para encontrar temas recurrentes en los datos, siempre desde un marco general, ya que puede admitir muchas lecturas desde marcos disciplinares diferentes.

El autor sugiere para este análisis el propuesto por Romano et al. (2003) el que se sintetiza en el siguiente cuadro:

Fuente: (Rham-Skageby, 2011)

En esta propuesta hay una clara inmersión y participación en la comunidad desde las categorías teóricas del investigador desde la cual se selecciona, codifica y hace interpretaciones desde los referentes teóricos para agregar y producir los resultados de la investigación.

Para la presentación de los resultados se propone en primer lugar el uso de cualidades como las propiedades de un diseño digital que es experimentado en su uso, cualidades que no siempre convergen en una misma dirección pero que justamente pueden permitir comparabilidad en el uso.

En segundo lugar se puede proceder analíticamente para relacionar y contrastar la complejidad del conflicto estudiado. Sirve para presentar integralmente un respaldo para la comparación en varios casos específicos. Cuando se identifican los extremos en un determinado conflicto resulta muy útil para postular, identificar e investigar actividades, preocupaciones e intenciones entre los extremos.

Luego del análisis y el uso de cualidades emerge un patrón de diseño el cual es una exposición estructurada de una solución genérica a un problema en un contexto de comunidad virtual. El patrón de diseño puede emerger de diversas formas, unas más funcionalistas u otras más narrativas pero casi siempre se componen de un nombre, la descripción de un problema así como del contexto, las fuerzas en juego y una solución genérica, los que se pueden llevar directamente a las comunidades estudiadas para su discusión y retroalimentación, con lo que se dará un mayor respaldo y cobrará mayor validez.

El enfoque de etnografía on-line parece ser muy interesante por su aparente facilidad de acceso, sin embargo como el propio autor lo resalta tiene unas ventajas y limitaciones que son de atención. En primer lugar están las características propios del contexto virtual y es que se mueve esta comunidad en lo global, anónimo, interactivo, mediado y manipulable. Esto puede redundar en un direccionamiento de ciertos participantes porque son los únicos interesados y se aparta de la realidad de toda la comunidad, efectos por la diversidad de tecnología que media la interacción, la identidad, el anonimato y el seudonimato preocupan metodológicamente.

Otro aspecto a resaltar es la transferibilidad y credibilidad de los estudios bajo este enfoque. Sin embargo estos aspectos no son más preocupantes que en cualquier otro estudio cualitativo. Aun así, la credibilidad depende siempre de los grados de consistencia con los usos y prácticas que en las comunidades se presenten así como su limitada transferibilidad. Casi que ningún estudio cualitativo tiene pretensiones de generalización, aun así, es posible su valor heurístico para otros casos, objetos o estudios, que se aborden desde el mismo enfoque teórico y categorial.

Finalmente la confirmabilidad y la fiabilidad son factores a considerar en la etnografía on-line. De un lado, se espera que los resultados puedan ser confirmados por otros y que las descripciones de los investigadores sean lo más precisas para poder confiar en estas. Esto debe matizarse pues los modelos y teorías desarrollados, no siempre son acabados y genéricos además de reconocer que en investigación cualitativa no se puede medir dos veces lo mismo de la misma manera.

La etnografía on-line se ha presentado como un enfoque versátil en el contexto de las comunidades virtuales. Un punto a considerar es la limitación que este enfoque conlleva. En primer lugar no son comunidades heterogéneas y mediadas solo por lenguaje, sino que hay un sesgo en el tipo de comunidad pues son activistas en las redes sociales. Esto nos ubica en un terreno que no necesariamente es representativo cualitativamente hablando. Otro elemento es la incursión de los bots con fines estratégicos de persuasión y coacción. Internet es un ecosistema en donde se conforman comunidades de diversa naturaleza que se oscurecen con factores característicos como el anonimato y el seudonimato, que transforman las interacciones y las desnaturalizan, por tanto no es clara la naturaleza del objeto que se estudia. Pero puede ser un prejuicio buscar comunidades humanas, auténticas, reguladas y civilizadas en un ecosistema en el que no se hallarán, por tanto lo que se debe considerar es la propia naturaleza del lazo social en la red y a partir de esto hacer las aproximaciones etnográficas.

Referencias

Pudaruth, S., Moheeputh, S., Permessur, N., & Chamroo, A. (2018). Sentiment Analysis from Facebook Comments using Automatic Coding in Nvivo 11. Advances in Distributed Computing and Articial Intelligence Journal, 7(1), 41- 48.

Rham-Skageby, J. (2011). Online Ethnographic Methods: Towards a Qualitative Understanding of Virtual Community Practices. En D. Ben, Handbook of Research on Methods and Techniques for Studying Virtual Communities: Paradigms and Phenomena. (págs. 410-428). Hershey: IGI Global.

Teoría Fundamentada y Codificación – Reseña MMCORRAL

Maria Mercedes Corral Strassmann

Septiembre 27 de 2020

Introducción

Diferentes métodos de la teoría fundamentada pueden complementar otros enfoques de análisis cualitativo para la investigación. Los capítulos para presentar muestran los principios de la teoría fundamentada de Glaser & Strauss (1967), su sentido en el análisis cualitativo y su definición. Adicionalmente se presenta a través de varios ejemplos y situaciones la codificación en la teoría fundamentada mostrando a través de esta situación esquemas de codificación y su funcionalidad y beneficios. Esta reseña busca mostrar algunos elementos importantes de la teoría fundamentada y la formas de realizar la codificación. Esta práctica requiere “hacer una alto y generar preguntas analíticas de los datos que hemos conseguido”. (Chazmar, 2006, p57). La codificación en la teoría fundamentada está definida en fases y en esta reseña se presentarán algunos elementos de estas fases.

Dentro del proceso de investigación, los métodos de la teoría fundamentada nos permiten iniciar, generar proceso y llegar al final con los resultados, esta teoría se fundamenta en la analítica de los datos, y nos permiten explorar y generar análisis en etapas tempranas de la investigación con base en los datos recolectados y de esta manera construir la teoría para la investigación. El proceso desde la recolección, estudio, y escritura de memos o notas sobre los mismos, permite llegar a las categorías de análisis.

Esta teoría fundamentada nace con los sociólogos Barney G. Glaser y Anselm L. Strauss’s (1965, 1967), quienes exploran los análisis basados en ideas de conversaciones y notas de observación de situaciones en casos de enfermedad, estos datos permitían posteriormente estudiar otros frentes, la idea de la teoría de acuerdo con Glaser y Strauss es desarrollar teorías de investigaciones basadas en datos en vez de comprobar hipótesis de teorías existentes, los autores proponen que los mismos análisis de los datos con su propia lógica lleguen a determinar la teoría. Para los autores de esta teoría fundamentada, los siguientes componentes deben estar presentes: la recolección, y análisis de los datos la construcción de los códigos y categorías a partir de los mismos datos, y establecer comparaciones dentro del análisis. La escritura de los memos ayuda en el proceso de categorización y la definición de relaciones entre las mismas categorías. Este método complementa otras aproximaciones al análisis cualitativo sin estar en oposición a estos otros métodos, algunos autores no comparten este esquema de realizar análisis cualitativo, la teoría fundamentada nos da elementos adicionales sobre los datos puesto que no guía en la forma de proceder en la investigación y análisis. Sin embargo, esta teoría es un desafío a los métodos cuantitativos,

El proceso de la teoría fundamentada lo presenta (Chazmar, 2006, p11) en un diagrama de proceso que contempla las diferentes actividades que conlleva el mismo, incluyendo los subprocesos y actividades ya mencionadas.

Revisando entonces los diferentes subprocesos tenemos, la codificación cualitativa como ese proceso de poder determinar cuáles son los datos y el significado de estos y esta codificación nos va a permitir iniciar con interpretaciones cualitativas. La codificación consiste en dividir los datos por segmentos que se puedan categorizar, y se nombran los segmentos por estos códigos. Los códigos muestran cómo se estructuró la data para el proceso analítico, el esquema es segmentar los datos y asignar códigos cualitativamente que permitan la interpretación de los segmentos de texto, en un proceso posterior.

Para la historia que se toma en el capítulo como referencia se determinan unos códigos que reflejan la situación de entendimiento y conocimiento ente las dos personas que son parte de la situación. Los códigos asignados reflejan significados y acciones o eventos propios tomadas dentro de la historia.

La Codificación en la Teoría fundamentada

La codificación en la teoría fundamentada es el inicio del proceso de análisis y es a través del cual se constituyen los elementos básicos. La codificación es la que permite la construcción del análisis y la integración posterior en el proceso de ensamblar los elementos. La codificación es por lo tanto el enlace entre la consecución de los datos y la teoría de su interpretación y explicación, y se constituye en los elementos que permiten la identificación de los significados en los textos. La codificación en la teoría fundamentada tiene dos fases, la fase inicial de codificación y la fase de codificación focalizada. En la fase inicial se define el esquema a utilizar y se codifica de acuerdo con este, sea por palabra, línea, segmento, y para la segunda fase se prosigue con la analítica. La codificación cualitativa es ese proceso que nos permite dar el sentido a nuestros datos y al análisis que vamos a realizar.

En la codificación cualitativa el elemento fundamental es el lenguaje y se genera una interacción permanente con los datos y lo que ellos puedan significar; esta codificación difiere totalmente de una lógica cuantitativa de análisis. A nuestra decisión los códigos definidos encajan en las acciones y los eventos reflejados en la data recolectada.

Cuando se inicia el proceso de codificación nos debemos hacer algunas preguntas que nos permitirán avanzar en el análisis, entre estas están, ¿de que tratan los datos? (Glaser, 1978: 57; Glaser y Strauss, 1967) ¿Qué sugieren? ¿Quiénes están en los datos? ¿qué categorías especifican los datos? (Glaser, 1978), en el proceso no se deben desatender los eventos internos a los datos puesto que esto llevaría entonces eventos externos que permitirían otros análisis y eventualmente otras conclusiones.

Entrando más en el detalle de los esquemas de codificación en la fase inicial, se tienen:

Codificación palabra-palabra, este esquema, es más útil cuando se tienen ciertos documentos o datos de internet, esta codificación nos obliga a revisar los significados de las palabras, en cada sitio del documento

Codificación línea-línea, este esquema significa, nombrar cada línea de los datos asignando un código (Glaser, 1978). Esta codificación puede ser útil en datos que provienen de entrevistas, observaciones, documentos, así mismo este proceso puede permitir una siguiente fase y reenfocar las entrevistas por ejemplo, así como nos permite revisar los datos que se deben recolectar posteriormente.

Codificación incidente-incidente, en esta codificación se comparan incidentes, o eventos y permite conceptualizar estos incidentes a lo largo del proceso, volviendo sobre codificados anteriores.

Glaser y Strauss (1967), proponen establecer métodos comparativos, que permitan generar comparaciones y distinciones analíticas, entre los datos recolectados. Adicionalmente se tienen los códigos “In vivo”, los cuales nos pueden representar elementos simbólicos de quienes participan en los datos y los significados.

La siguiente fase de la codificación o codificación focalizada, la cual es más conceptual y selectiva que las mencionadas en la fase inicial, esta fase utiliza los códigos iniciales focalizados en las conceptualizaciones que se requieran. Este esquema de codificación requiere decisiones sobre cuales códigos iniciales tienen más sentido analítico para el proceso siguiente.

Otro tipo de codificación es la codificación axial, propuesta por Strauss y Corbin (1990, 1998; Strauss, 1987), la cual relaciona categorías a subcategorías especificando las dimensiones propias de cada categoría y permite reensamblar el texto que se ha trabajado con las codificaciones anteriores y tenerlo nuevamente para el análisis. Este método de acuerdo con los autores Strauss y Corbin (p.125) responde algunas preguntas del análisis como, que, como, cuándo, done entre otras, estas preguntas permiten a los investigadores describir más detalladamente el estudio que se esté llevando a cabo.

Glaser (1978:72), introduce un nuevo esquema de codificación que es la codificación teorética con la que se definen niveles de codificación más complejos, y los cuales se relacionan entre ellos y pueden ser parte de la teoría; adicionalmente permite establecer relaciones con las categorías definidas en la codificación focalizada. Esta codificación teorética adicionalmente direcciona el análisis.

Es importante tener presente que dentro del proceso de codificación se pueden presentar dificultades debido a varias causas como códigos muy generales, identificación de temas en vez de procesos, errores en el contexto de los códigos entre otros.

Algunas conclusiones, en la teoría fundamentada, el análisis se sustenta en los datos, no en teorías, por lo tanto las fases de decisión de los datos y la recolección son fundamentales para realizar el análisis, y se puede volver sobre los datos y afinarlos. Es flexible y permite decisión del investigador. La codificación es fundamental para el análisis y la interpretación de los datos.

La teoría fundamentada ha sido cuestionada pero es decisión del investigador y del objetivo de la investigación que sea la metodología de análisis adecuada.

Para mi proyecto de métodos de investigación, la teoría fundamentada utilizando Nvivo como herramienta de codificación y análisis puede ser interesante para los datos recolectados, y el objetivo del proyecto. Los datos consisten básicamente, en los proyectos definidos en la estrategia de la PUJ 2016-2021, los cuales se encuentra publicados en video, donde se reflejan los proyectos sociales enfocados en la tercera misión o misión de servicio. El proyecto busca analizar la concepción de la PUJ frente a la tercera misión, y entender si los objetivos de los proyectos y los mensajes que los videos entregan a la comunidad si se enfocan en la tercera misión. Este proyecto hace parte del proyecto de investigación doctoral.

Referencias

Charmaz, K. (2006), Ch.1. ‘Invitation to Grounded Theory’ y Ch.3. ‘Coding in Grounded Theory Practice.’ http://www.sxf.uevora.pt/wp-content/uploads/2013/03/Charmaz_2006.pdf

Glaser, B. G. (1978). Theoretical sensitivity. Mill Valley, CA:The Sociology Press.

Glaser, B. G., & Strauss, A. L. (1965). Awareness of dying. Chicago:Aldine. –. (1967). The discovery of grounded theory. Chrcago:Aldine.

Strauss, A., & Corbin.J. (1990). Basics of qualitative research: Grounded theory procedures

—-. (1998).Basics of qualitative research: Grounded theory procedures and techniques (2nd ed.). echniques. Newbury Park, CA: Sage.

Strauss, A. L. (1987). Qualitative analysis for soda/ sdentists. New York: Cambridge University Press

Reseña Crisis económica y financiera mundial y opinión periodística editorial (Iván Rodrigo Mendizábal)

Por: Henry Romero

El estudio presentado sobre análisis del discurso en las comunicaciones en Ecuador, relativas a la crisis económica y financiera desencadenada en los Estados Unidos en el año 2008, es un ejemplo del cual se pueden extraer importantes ideas sobre la práctica del análisis del discurso y los resultados que este puede arrojar. En esta reseña se destaca las principales ideas del estudio, pero igualmente se hacen observaciones críticas al respecto.

El estudio se centra en un análisis del discurso sobre la manera en que los medios de comunicación escrita más relevantes de Ecuador en sus editoriales cubrieron la crisis que se desencadenó en los Estados Unidos en el año 2008 y que trascendió dichas fronteras. La orientación del investigador estuvo determinada por la pregunta ¿de qué manera los editoriales y los artículos de opinión, publicados en las páginas de los principales diarios ecuatorianos, hicieron comprensible la gravedad de la crisis al público ecuatoriano, profundizando en su análisis?

Para los fines del análisis se tomaron las editoriales de los cuatro principales diarios de Ecuador en sus secciones editoriales durante el mes de abril del año 2009, delimitando el alcance solo a las opiniones editoriales y diferenciándolas de las secciones económicas especializadas de los propios medios, para reconocer algunas características. Se partió de la creencia que las editoriales siempre se hacen de un lugar de enunciación, no son neutrales y pretenden incidir en la opinión publica. Por tanto el estudio abordó el contenido semántico y las formas argumentativas a través de partes y jerarquías como frases, agentes de poder, los manejos del lenguaje, estrategias de discurso, evidenciando valoraciones y juicios, propósitos, prejuicios y como discurso ideológico se analizaron las valoraciones explícitas e implícitas, indagando el uso retórico de las palabras, eufemismos, metáforas intencionadas y estereotipos. En este sentido, aunque el autor no lo nombra de esta manera, lo que hace es análisis crítico del discurso y no solo análisis del discurso.

Los referentes de la crisis del año 2008 describen una serie de prácticas en los mercados financieros que implican altos riesgos en los usos de los recursos financieros, especialmente en lo relativo al otorgamiento de créditos hipotecarios a personas con alto riesgo de impago, este tipo de circunstancia es muy sensible a las bajas de precios en los bienes raíces, lo que fácilmente puede desencadenar impagos en los créditos y al ser lo suficientemente estructural esta modalidad para los bancos se ven comprometidos igualmente en sus obligaciones. En paralelo a esto, se cita la crisis de 1929 y resultan encontrándose similitudes en especial en la falta de regulación y como bien lo sostiene el investigador y es que “el problema esencial de la crisis fue y sigue siendo el cálculo especulativo” (Mendizábal, 2010, pág. 128). En este punto ya se puede sostener que hay dos problemas, uno el real y dos el de la comunicación del problema, a esto deberíamos sumar los problemas inherentes a la naturaleza de la información económica y financiera que es fuente para el comportamiento en el mercado.

La importancia de los asuntos económicos para la opinión pública es de las mayores, por tanto las responsabilidades que las comunicaciones sobre esta adquieren un grado de responsabilidad del mismo nivel, dado que el impacto que tienen en la vida cotidiana tanto de los grandes inversionistas como del ciudadano común es real. A pesar de esto, hay un posicionamiento del editorialista que puede asumir tendenciosamente movido por el interés del propio medio o por intereses particulares como puede ser natural en toda opinión. La comunicación económica tiene un doble efecto y es que directamente se puede emplear como fundamento en una decisión económica y a su vez es direccionadora de la opinión pública.

Los editorialistas de los cuatro medios objeto de análisis son expertos económicos de orden mundial y regional que escriben para un público interesado, de clase media, con formación mínima superior y con cierto nivel de experticia y familiaridad en los temas económicos. Quiere decir esto que los medios eligen a su público en estos temas.

Identifica redes semánticas que configuran el discurso periodístico. En primer lugar una red que denota los análisis orientados desde las críticas al capital especulativo y las consecuencias del neoliberalismo. En segundo lugar una red que gira alrededor de los actores involucrados en la crisis, responsabilidades, efectos y beneficiados como en el caso de China, que incursiona como compradora de los bonos del gobierno norteamericano pero para asegurar beneficio en el comercio de sus productos, en esta se halla una alta presencia ideológica en el discurso periodístico, y evidencia que los actores emergentes a partir de la crisis y las implicaciones para un escenario multipolar y altamente competitivo como lo que se desprende del posicionamiento de China. Otra red semántica permite identificar las estrategias a seguir para superar y recuperarse ante la crisis que, centradas en las políticas del gobierno norteamericano pusieron en evidencia el carácter privado de las ganancias y la responsabilidad pública de las perdidas y rescates. Del mismo modo las opiniones de expertos especialistas giran alrededor de la defensa del sistema y de las estrategias de los organismos financieros multilaterales. Una cuarta red y eje discursivo gira alrededor del impacto en la moneda ecuatoriana, dado que su economía se dolarizó en 1999, por tanto esta crisis natural en los Estados Unidos, y en general cualquier otra, tendrá efectos directos en la economía ecuatoriana, lo que hace que tratadistas especializados siempre vean esto como un tópico de interés. Finamente se detecta una quinta red semántica centrada en las criticas al gobierno del presidente Rafael Correa en su proceder frente a la crisis dada la dolarización de su economía.

Resultado del estudio se presenta el carácter discursivo empleado y se encuentra que tienen vertientes hacia la argumentación y la cognición, con fines didácticos para ilustrar a los lectores y explicar la naturaleza de la crisis; interacción y persuasión, con fines estratégicos e ideológicos y también planteando dilemas y esperanzas, tomando en cuenta la coyuntura que se vive. Desde los recursos retóricos la investigación evidencia el uso de metáforas, ironía, elogio, aprobación o reprobación inmersos en los diferentes discursos periodísticos.

Se llega igualmente a que las representaciones en los diarios analizados son de naturaleza ideológica a través de la cual se trata de persuadir, apelando a los sentimientos de duda o de certeza del lector.

La conclusión configurada es que en la narrativa implícita en el discurso global hay cuatro hechos con su respectivo corolario:

- la crisis económica y financiera es producto del juego especulativo que pone en cuestión el neoliberalismo y el estado de bienestar.

- existen estrategias globales y locales donde aparecen juegos de poderes en defensa del sistema capitalista.

- las economías emergentes hacen imaginar un panorama de inseguridad dado que han surgido de esquemas diferenciales a los que occidente está acostumbrado.

- la crisis económica y financiera mundial tampoco es el espacio que se pueda aprovechar para cambiar la moneda en Ecuador y por el contrario hay que sostenerlo dados los efectos positivos que esto le ha traído al país.

Al margen del fondo tratado en el estudio de Mendizábal, que en ocasiones no parece que haga un análisis del discurso, sino parece que está haciendo un análisis de los hechos, y de los problemas de comunicación de medios, es posible hacer unas notas criticas alrededor de su estudio.

La separación de dos discursos intencionadamente hace pensar que en el propio planteamiento del estudio, se tiene la creencia que las secciones editoriales, por ser de opinión tienen un sesgo ideológico y las secciones especializadas, si bien no carecen de este, no es tan marcado como en las opiniones de los editorialistas. Desde la perspectiva económica, esta es una creencia que se ha fortalecido, pero que no es del todo precisa. Las secciones económicas por ser más especializadas tienden a ser más explícitas y técnicas. Aun así, los problemas que el autor bien diagnóstica alrededor de los sesgos ideológicos presentes por la condición de medio y el impacto que este puede generar, así como por el posicionamiento de los editorialistas, en el caso de la información económico financiera las estructuras propias de la información, los datos, los criterios técnicos, etc. son en sí mismos ideológicos. En este estudio, con la separación que se realiza entre editorial y secciones especializadas económicas, se pretende enfocar en lo aparentemente interpretativo, no neutral e ideológico, la sección editorial interpretativa y subjetiva por naturaleza, se cree está elaborada sobre una base objetiva de datos y cifras económicas, sin embargo lo que se cree objetivo en términos económicos y financiero no es tal. Los datos económicos son formas interpretativas que también son no neutrales. Para sostener esto, basta con pensar en la realidad productiva de las empresas y su valoración en la bolsa. Son solo expectativas. Y justamente las expectativas son configuraciones de creencias apoyadas en aparentes opiniones objetivas y datos de expertos, no de editorialistas, que en rigor serian lo mismo.

Valga decir igualmente que desde la perspectiva de la comunicación periodística se trata en términos generales de describir y que por esto es un detonante de percepciones de la ciudadanía, pues están forjando el clima de opinión. En rigor, en las crisis, cualquiera que estas sean, la comunicación sobre ellas se convierte en un factor más de la propia crisis, si no, en el propio detonante de la misma, pues es a través de esta que las reacciones sociales se generan.

Metodológicamente la investigación hace un análisis del discurso a profundidad pues no emplea software de lexicometría y va más allá de una interpretación de datos de frecuencias. Recurrencias y relaciones terminológicas cuantitativamente hablando. Analiza extractos de las editoriales y hace interpretación semántica e inferencial que ubica y segmenta en las cinco redes semánticas que describe. Este proceder, si bien tiene la bondad de ser profundo y no solo cuantitativo, deja entrever el carácter subjetivista del análisis del discurso. Es un buen ejercicio para sacar a la superficie cómo un equilibrio en el análisis del discurso es necesario para una mayor validez y legitimidad en términos epistemológicos.

El artículo presenta igualmente un sentir del momento por el clima de opinión desencadenado por la crisis y por la forma como los medios crean la percepción de la misma. Al poner de manifiesto que la crisis parece ser el fin de un período del capitalismo y la apertura de otro, no es más que un imaginario que dispone el papel de los medios que se basan ya sea en realidades o en quimeras y que resulta configurando percepciones e induciendo sentimientos que crean esferas tendenciosas y muy alejadas de la realidad asentando un carácter constructivo de la realidad y no descriptivo como pretenden ser.

Trabajos citados

Mendizábal, I. R. (2010). Crisis económica y financiera mundial y opinión periodística editorial. Comhumanitas, 1(1), 123-154.

La construcción de la noción de justicia