Por: Luis Felipe Navarrete

En el apartado 11 Klaus Krippendorff amplía la reflexión en torno a la confiabilidad en la investigación científica, extendiendo la mirada a elementos como la muestra, la representatividad, la validez, la replicabibilidad, entre otros (como el uso de la estadística, las distribuciones y los estándares), haciendo un recorrido por modelos, formulas y parámetros que han permitido avanzar en la gestión de tan exigido criterio.

De entrada demarca tres criterios desde los cuales se busca establecer y concretar la confiabilidad: estabilidad, reproducibilidad y precisión, en relación a la obtención de datos de confiabilidad.

La estabilidad se refiere a la constancia del proceso en el tiempo y se evidencia en la repetición de ensayos y la obtención de mismos resultados. Se requiere revisión de pruebas por parte de otros observadores en una prolongación de tiempo para registrar su continuidad; si hay variaciones no se cumple con este componente. De allí la necesidad de clarificar los criterios de clasificación. Krippendorff aclara que esta tipología es la más “débil” y resulta insuficiente como criterio único de confiabilidad, pero puede verse como un primer paso o nivel.

La reproducibilidad se asocia a la posibilidad de que el proceso se replique –o pueda serlo- por parte de otros analistas (que operan en otras condiciones, entornos o con instrumentos diferentes-pero equivalentes); este procedimiento alude a la acción de inter-codificación, acción que acentúa una fiabilidad mucho más sólida que el proceso anterior.

La precisión remite al ajuste de las especificaciones y el manejo de datos en condiciones estándar de prueba, lo cual se extiende a la generación de procedimientos que acompañen el procedimiento central, aspecto que usa la verificación, el contraste, la mirada del experto y el refinamiento de los sistemas de evaluación.

Se resalta la relevancia de la confiabilidad de los datos como punto que cimenta los niveles de razonamiento, análisis y el establecimiento de conclusiones; de allí la urgencia de evitar sesgos, refinar los datos, sistematizaciones pertinentes, definiciones bien establecidas, entre otros. Retomando a Kaplan y Goldsen (1965) se señala que la confiabilidad da seguridad sobre los datos independientes del evento de medición, dan constancia al trabajo y permite escapa a las variaciones de las circunstancias. De allí la vitalidad de estipular la fiabilidad.

En las dimensiones contempladas se hace mención de los niveles de comparación (de dos observadores), de la riqueza de la discusión en la comunidad académicas, de las sustentaciones empíricas, de la necesidad de diseños que no impliquen variaciones, estrategias para expulsar el “ruido”, muestras o cantidades que resulten representativas (atendiendo a las característica de los universos) la potencia de la lectura de los datos textuales y las extensiones analísticas derivadas de instrumentos –replicables y demostrables- que permitan concretar amplios márgenes de concordancia (como una posibilidad interpretativa asociada a la fiabilidad), que puntualizan la vitalidad de definir unos criterios de confiabilidad que permitan sustentar las conclusiones en la estructura confiabilidad: garantía: resultados.

En el proceso de codificación del material textual, se resalta que la deficiente fiabilidad repercute en la validez, lo cual hace que la debilidad de la confiabilidad se vea materializada en conclusiones débiles o fácilmente refutables. En esa misma línea analítica se destaca que “la fiabilidad no garantiza a validez”; el sesgo disciplinar, cosmovisiones, inciden en la interpretación: los datos no hablan solos, sino que se traducen en las codificaciones que pueden estar erradas y maltratar los datos. De esta manera “la fiabilidad es una condición necesaria, pero no suficiente, para la validez”. Se añade a esto que “Lo atractivo no necesariamente es fiable “– lo cual hace cuestionar su validez: ejemplo señalado es el trabajo sobre “topónimos” de Merrit (1966).

En la problematización sobre la valides se señala que el uso de mecanismos computacionales, que aparentemente aumentan la confiabilidad, también han suscitado reflexiones y problematizaciones, porque si bien procesan caracteres, no lo hacen con los significados. Si el investigador programa mal, la computadora continua el procedimiento “clasifica amplios volúmenes de palabras sin atribuirles sentidos”… De allí la necesidad de segundos observadores y las revisiones de expertos.

Ahora, si bien la mirada del experto contribuye a afianzar una confianza en la generación de datos, no debe omitirse que, desde la dimensión de la reproducibilidad, se requiere que cualquier investigador pueda ejecutar la acción de codificación y operacionalizar desde las categorías utilizadas en la investigación. .

Un método de validez mencionado en el capítulo corresponde a la técnica que hace que los analistas dividan las muestras en unidades –aproximadamente- iguales para dar cabida a codificaciones diferencias (por observadores diferentes) para luego pasar a una comparación de las frecuencias y demás resultados obtenidos; si las diferencias eran mínimas se demarcaba la confiabilidad. A pesar del alcance de este procedimiento, se cuestiona en tanto se reduce a la nivelación de dos sub muestras (de allí que llegue a desaconsejarse su uso).

Condiciones de prueba, según Krippendorff:

- Clara formulación de las instrucciones de codificación.

- Trabajo independiente de los observadores (para descartar un consenso encubierto)- “La reproducibilidad requiere al menos dos observadores independientes” “la literatura de análisis de contenido está llena de evidencia de los intentos bien intencionados pero a menudo equivocados de los investigadores para manipular el proceso de generación de datos para aumentar la apariencia de niveles de acuerdo” (Krippendorff).

La independencia resulta clave puesto que, en muchos trabajos, el investigador acude a la interpelación de analistas amigos o con quienes ha trabajado durante algún tiempo. Esto puede producir sesgos, en tanto el acuerdo puede estar edificado no tanto desde la calidad de las indicaciones, sino desde acciones como el “ser colegas” o por el conocimiento previo de los objetivos de investigación.

Respecto a los procedimientos, aparece como práctica la actualización o ampliación de las instrucciones de codificación; si bien es posible marcar pautas desde la evolución de los procesos, es clave no confundir eso con el cambio de reglas.

En relación a los datos, muchos analistas se limitan considerar solo las unidades que logran concatenar un acuerdo, lo cual representa una problemática en tanto “la persecución de la confiabilidad” puede obnubilar la precisión de criterios que delimiten dicha exigencia. De allí que se omitan unidades en las que los codificadores no presenten acuerdo, pero que pueden ser significativas. Una de las posibilidades reflexivas ha sido el diseño de tablas de coincidencia. Otro de los procedimientos consiste en la acción de tres o más observadores independientes – el uno del otro- que garanticen la fiabilidad, para luego recoger las discrepancias a través del establecimiento de criterios formalizados (por ejemplo, por promedios).

Se enfatiza en la necesidad, desde cualquier procedimiento, en la confiabilidad consistente en registros (generalmente establecidos desde dos revisores, observadores o mecanismos de medición) que consideren dos de las rutas de creación de datos de confiabilidad como la unificación y la codificación, aspectos que pueden ser concurrentes y simultáneos (aunque los mecanismos matemáticos para su evaluación sean distintos).

El primero –unificación-obedece a la identificación, dentro de un medio, en espacios contiguos información que conecta con la pregunta de investigación (que conlleva acciones como articulación de notas de un periódico, o la demarcación de partes de un video). Se pueden considerar su comienzo y su longitud, expresadas en números enteros, y precisa de por lo menos dos observadores que “unifiquen los mismo”.

El segundo –codificación- remite a la trascripción, “categorización e interpretación” de las unidades de análisis, para favorecer las comparación y análisis, donde se pueden hacer descripciones o interpretaciones específicas o múltiples, teniendo en cuenta elementos como “longitud, duración, tamaño” que requieren de un diseño apropiados de instrucciones, que permitan establecer a su vez categorías, rangos, escalas, medidas que, por claridad, deben ser “mutuamente excluyentes” en aras de evitar la ambigüedad.

Se identifican también dos tipos de errores que generan valores negativos: los errores de muestreo, reflejados en la falta de justificación de las muestras o en la falta de representatividad, que aparece, por ejemplo, en muestras pequeñas; y los desacuerdos sistemáticos.

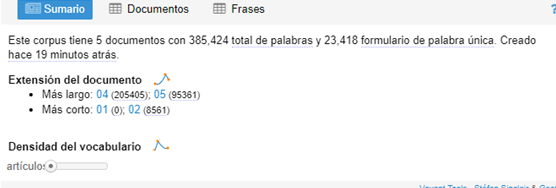

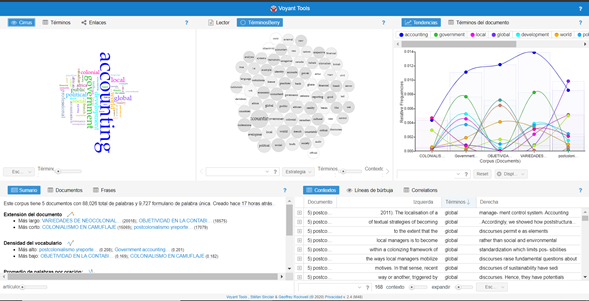

Para enfrentar esto, se han postulado los desarrollos de matrices de confiabilidad, que permiten tener una visión más clara y que pueden partir de elementos básicos como el registro de los valores asignados a las unidades por los observadores, como se expresa en la siguiente figura:

Figura 1. Tomada de: Krippendorff, K. (2013) Content Analysis. An Introduction to Its Methodology (3rd ed). Chapter 11. Reliability. California, CA: Sage Publications.

Se identifican las métricas nominales, ordinales, de intervalo y de relación

Cuatro medidas o condiciones de aceptación o rechazo de la confiabilidad de las medidas: Variación insuficiente (desviaciones), consideraciones de muestreo (de la representatividad de los datos a su confiabilidad), significación estadística y estándares para la confiabilidad de los datos. Aquí se aclara que en el análisis de contenido usan variables como publicación, fecha, medida; aspectos que por su claridad resultan confiables.

Si bien la fiabilidad es un criterio cave para la valides de los resultados, muchos trabajos no declaran las evaluaciones de confiabilidad, como lo identificaron Riffe y Freitag (1996), o no aplican métodos de cálculo (Kolbre y Burnett, 1991) e inclusive, su confiabilidad puede ser discutida (Krippendorff’s u. Lombard, SnyderDuch, y Bracken 2002). La confiabilidad debe considerarse desde el inicio de la investigación; en la generación de datos, transcripciones, este aspecto debe ser ya considerado, en tanto, la confiabilidad de los datos da luz verde a un trabajo más efectivo.

Se acentúa la necesidad de reconocer la naturaleza de los datos y el sentido de las operaciones y formulas establecidas en el establecimiento de las métricas (manifestando la claridad de las variables y las operaciones estadísticas o matemáticas aplicadas) pues esto determina la acción y sentido del proceso, como por ejemplo: “el análisis de varianza requiere datos de intervalo, las contingencias se calculan a partir de datos nominales”.

La confiabilidad se ha concretado en el consenso; el acuerdo alcanzado por codificadores en relación a los instrumentos de medición. El coeficiente presentado por Krippendorff se ha postulado como insumo que determina el acuerdo y teniendo en cuenta los datos nominales, las métricas, los observadores y los datos (completos e incompletos).

En atención a estos procedimientos, se considera la riqueza multi-formal de las unidades del análisis de contenido, que comprende desde textos –segmentos o totalidades-, imágenes, fotografías, audios, videos, programas de tv, películas, páginas web; estructuras textuales de relevancia para los analistas.