Aunque usan el mismo objeto de estudio: un conjunto de textos en el sentido amplio (que puede abarcar textos escritos, imágenes, audio, video…), el método de análisis de contenido cuantitativo y el método de análisis de contenido por medio de codificación cualitativa parten de premisas diferentes para desarrollar sus metodologías: mientras que el primero supone un sistema de reglas sistemáticas (es decir que abarcan por completo el corpus posible), replicables con exactitud y con resultados determinísticos; el segundo supone un proceso más ponderado de interpretación inferencial y abductiva, en la que el investigador codifica los textos de su corpus de acuerdo a diferentes estrategias como la codificación exploratoria (más que todo intuitiva), la codificación in vivo (usando los mismos términos que los participantes), la codificación descriptiva (que anota metódicamente pequeños términos), etc.

La principal ventaja del análisis de contenido cuantitativo es que, gracias a sus reglas “objetivas” (o sea, determinísticas, según la definición de Andréu Abela (2000)), permite detectar patrones de superficie en la forma de los textos que se están estudiando. Estos patrones, a su vez, y dependiendo del tipo de texto recogido, pueden permitir encontrar esquemas narrativos, usos lingüísticos repetidos, relaciones entre unidades léxicas, y en general caracterizar los textos de acuerdo con estructuras formales a gran escala. Además, la transformación del contenido del texto en cuantificaciones numéricas desbloquea una serie de procesos estadísticos y algorítmicos que permiten revelar nuevas lecturas que, aunque están en el contenido “manifiesto”, no se hacen evidentes a simple vista. Por ejemplo, con los datos estadísticos se pueden hacer visualizaciones que muestran distribuciones de datos extraídos de los textos, o con algoritmos de clustering se pueden agrupar temáticas recurrentes.

En cuanto a la principal desventaja de la codificación cuantitativa, el contenido “manifiesto” puede llevar a interpretaciones de superficie que no dan cuenta de los sentidos complejos que puede connotar un texto. Un ejemplo claro son los distintos efectos semióticos y retóricos que suelen usar participantes cuando están hablando en un lenguaje cotidiano: sarcasmos (“¡bonitas las horas de llegar!”), metonimias (“hay que parar la fuga de cerebros”), metáforas (“x es un cerdo”), contrafácticos (“si hubiera dormido, no tendría dolor de cabeza), etc. Cuantificar contenido manifiesto suele partir de la suposición de que un signo léxico es una entidad estable de la que se pueden contar sus ocurrencias, o sea, que se puede suponer que la misma palabra en distintos contextos se refiere a lo mismo. Esto omite completamente los matices del lenguaje real bajo la apariencia de la sistematicidad. La noción de contexto ayuda a diferenciar con mayor profundidad las diferencias, pero, en ocasiones, una noción de contexto muy restrictiva, que también se supone como claramente definible, es insuficiente.

La principal ventaja de la codificación cualitativa, que para algunos puede también ser su principal defecto, es el aspecto interpretativo que ofrece lecturas complejas de los textos. Como afirman tanto Elliot (2018) como Saldaña (2013), la codificación, especialmente si se realiza relecturas y recodificaciones posteriores de los textos, les permite a los investigadores familiarizarse con sus objetos de estudio de una manera que no es posible con los métodos automatizados que ofrece la investigación cuantitativa. Tanto es así que Saldaña sugiere aprender a codificar a mano, con hojas impresas y esfero en mano, más que con software de anotación especialmente creado para métodos de investigación en ciencias sociales. Sin embargo, esto también puede resultar desventajoso en términos de escala y tiempo, por eso Saldaña destaca como uno de los atributos de un buen investigador de codificado a la “paciencia”. Los corpus demasiado grandes, tanto en el número de textos como en la extensión de los mismos, aumentan la dificultad de la codificación. En esos casos se necesita recurrir a la anotación grupal o al crowdsourcing (por ejemplo, creando proyectos de ciencia ciudadana), que permiten que múltiples investigadores o ayudantes anoten partes del corpus. Por supuesto, esto reduce la familiarización con el corpus que obtendría un solo investigador, introduce múltiples interpretaciones que pueden resultar contradictorias o inconsistentes, pero aumenta la escala a la que se puede realizar el proceso.

Tratar datos cualitativos como datos numéricos, por ejemplo, contándolos, puede dar paso a interpretaciones erróneas. Por ejemplo, la codificación —como advierten Elliott y Saldaña—, debido a que en buena medida es un proceso interpretativo, no va a producir con exactitud resultados “objetivos” en el sentido de Andreu Abela, es decir, determinísticos, que produzcan la misma salida si se dan los mismos datos de entrada. Así, contar el número de códigos que resultan de un texto darían más una impresión de los intereses del codificador que de la estructura del texto. No obstante, esto no es del todo negativo, si se tienen en cuenta las condiciones en las que se da la codificación, pues un conteo puede dar luces de patrones intuitivos que el investigador está descubriendo o hacia los que tiende su búsqueda, pero que no son todavía muy evidentes.

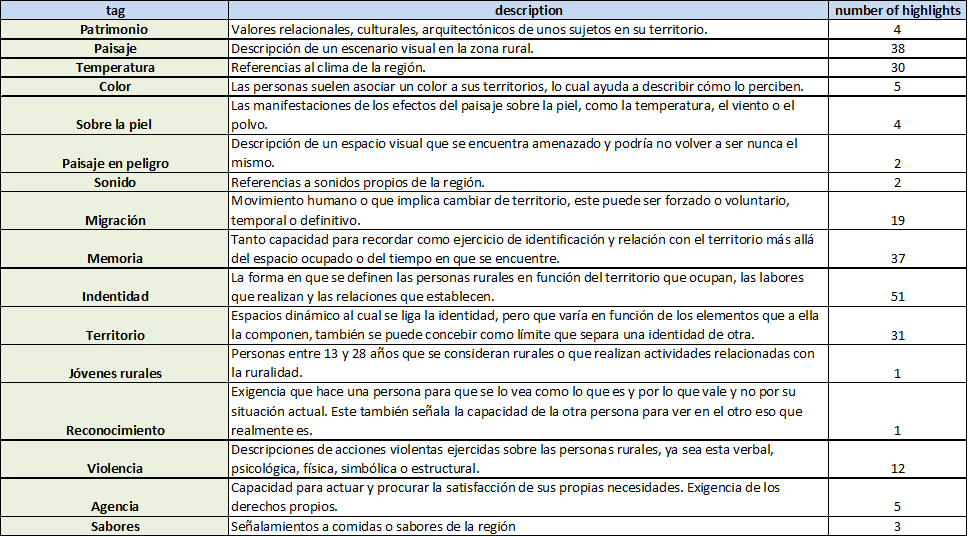

En cuanto a mi trabajo, considero que las dos metodologías pueden resultar útiles. El método de análisis cuantitativo puede servir para corpus extensos que tienen formatos relativamente preestablecidos y que no fueron recogidos por mi: entradas de blog, artículos académicos, proceedings de conferencias alrededor de las humanidades digitales, etc. Ese tipo de corpus puede encajar dentro de las premisas de análisis sistemático del análisis cuantitativo y, además, puede ser analizado en superficie para detectar patrones temáticos comunes en los textos. Por otra parte, el método de análisis cualitativo puede servir para los objetos textuales que estoy recogiendo yo mismo, especialmente las entrevistas a participantes de las comunidades nacionales en Latinoamérica. Como mi interés consiste en desarrollar un diagnóstico profundo de las dificultades, los horizontes y las diferencias que existen en la construcción de las humanidades digitales en nuestro contexto, la codificación cualitativa puede dar el nivel de detalle que necesito. Además, con los experimentos que ya he realizado, he notado que la codificación cualitativa efectivamente permite ver sentidos profundos que los participantes comunican y que no quedarían expuestos con un análisis cuantitativo.

Referencias

Andréu Abela, J. (2000). Las técnicas de análisis de contenido: Una revisión actualizada. Fundación Centro de Estudios Andaluces, Universidad de Granada.

Elliott, V. (2018). Thinking about the Coding Process in Qualitative Data Analysis. The Qualitative Report. https://doi.org/10.46743/2160-3715/2018.3560

Saldaña, J. (2016). The coding manual for qualitative researchers. SAGE.